É provável que as máquinas se tornem mais inteligentes que os seres humanos? “Não”, diz Jean-Gabriel Ganascia: trata-se de um mito inspirado na ficção científica. O cientista da computação nos fala sobre os maiores avanços em Inteligência Artificial (IA), revisa os avanços técnicos mais recentes e discute as questões éticas que pedem por respostas cada vez mais urgentes.

Por: Jean-Gabriel Ganascia

Fonte: Unesco Courrier (https://pt.unesco.org/courier)

CB2, um robô infantil, construído por Minoru Asada, Japão, que queria compreender como os robôs aprendem.. Aqui, o CB2 está aprendendo a engatinhar.

A Inteligência Artificial (IA) é uma disciplina científica que começou oficialmente em 1956, durante um workshop de verão organizado por quatro pesquisadores norte-americanos – John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon – na Universidade de Dartmouth, em New Hampshire, Estados Unidos. Desde então, o termo “inteligência artificial”, provavelmente criado para causar impacto, se tornou tão popular que atualmente todos já ouviram falar sobre ele. Este uso da ciência da computação continuou a se expandir ao longo dos anos, e as tecnologias criadas contribuíram enormemente para as mudanças do mundo nos últimos 60 anos..

No entanto, o sucesso do termo “inteligência artificial” é às vezes fundamentado em um mal-entendido, quando é utilizado para se referir a uma entidade artificial dotada de inteligência e que, como resultado, poderia competir com os seres humanos. Esta ideia, que se refere a mitos antigos e lendas como a de golem (do folclore judeu, uma imagem dotada de vida), tem sido revivida recentemente por personalidades contemporâneas, incluindo o físico britânico Stephen Hawking (1942-2018), o empreendedor norte-americano Elon Musk, o futurista norte-americano Ray Kurzweil, e defensores daquilo que chamamos atualmente de IA sólida ou Inteligência Artificial Geral (IAG). Nós não discutiremos este segundo significado aqui, porque, pelo menos por enquanto, poderá apenas ser atribuído à imaginação fértil, inspirada mais pela ficção científica que por qualquer realidade científica tangível confirmada por experimentos e observações empíricas.

Para McCarthy, Minsky e os outros pesquisadores do Dartmouth Summer Research Project (link is external)(Projeto de Pesquisa de Verão de Dartmouth) sobre Inteligência Artificial, a IA foi inicialmente projetada para simular as diferentes faculdades da inteligência – humana, animal, vegetal, social ou filogenética – utilizando máquinas. Mais precisamente, esta disciplina científica teve como base na suposição de que todas as funções cognitivas – especialmente aprendizagem, raciocínio, computação, percepção, memorização e mesmo descobertas científicas ou criatividade artística – podem ser descritas com tal precisão que torna possível programar um computador para reproduzi-las. Em mais de 60 anos de existência da IA, não há nada que tenha negado ou provado de forma irrefutável esta possibilidade, que permanece tão aberta quanto cheia de potenciall.

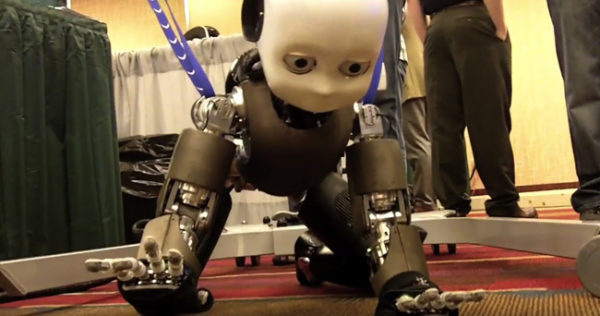

O ENIAC (Electronic Numerical Integrator and Computer), o primeiro computador eletrônico digital programável, construído em 1946, logo após a Segunda Guerra Mundial.

Progresso desigual

No decorrer de sua curta existência, a IA passou por diversas mudanças. Elas podem ser resumidas em seis fases:

O tempo dos profetas – Primeiramente, na euforia da origem da IA e seus primeiros sucessos, pesquisadores envolvidos em declarações imprudentes deram asas à imaginação, fazendo declarações irresponsáveis pelas quais foram, mais tarde, duramente criticados. Por exemplo, em 1958, o cientista político e economista norte-americano, Herbert A. Simon (EUA), que recebeu o prêmio Nobel de Ciências Econômicas em 1978, declarou que as máquinas se tornariam campeãs de xadrez dentro de dez anos, caso não fossem barradas das competições internacionais.

Os anos obscuros – Na metade dos anos 1960, o progresso parecia ser lento demais. Uma criança de 10 anos venceu um computador em um jogo de xadrez em 1965, e um relatório encomendado pelo Senado dos Estados Unidos, em 1966, descreveu as limitações intrínsecas das traduções automáticas. A IA recebeu críticas negativas por quase uma década.

IA semântica – Todavia, o trabalho continuou, mas a pesquisa tomou nova direção. A pesquisa focou na psicologia da memória, nos mecanismos do entendimento – com tentativas de simular esses mecanismos nos computadores – e no papel do conhecimento no raciocínio. Essa nova direção levou à ascensão de técnicas para a representação semântica do conhecimento, que se desenvolveu consideravelmente na metade dos anos 1970 e levou ao desenvolvimento de sistemas periciais, chamados desta maneira porque utilizam a sabedoria de especialistas habilidosos para reproduzir seus processos de pensamento. Os sistemas periciais despertaram enormes esperanças no começo dos anos 1980, com uma ampla gama de aplicações, incluindo diagnósticos médicos.

Neoconexionismo e machine learning – Melhorias técnicas levaram ao desenvolvimento de algoritmos de machine learning (aprendizagem automática ou aprendizado de máquina), que permitiram aos computadores acumular conhecimento para automaticamente reprogramarem-se, utilizando suas próprias experiências.

Isso levou ao desenvolvimento das aplicações industriais (identificação biométrica, reconhecimento de fala etc.), onde as técnicas de IA, ciência da computação, vida artificial e outras disciplinas foram combinadas para produzir sistemas híbridos.

Da IA para interfaces homem-máquina – Começando no fim dos anos 1990, a IA se juntou à robótica e a interfaces homem-máquina para produzir agentes inteligentes que sugerem a presença de sentimentos e emoções. Isso levou à ascensão, entre outras coisas, do cálculo de emoções (computação afetiva), que avalia as reações de um sujeito sentindo emoções e as reproduz em uma máquina, e especialmente do desenvolvimento de agentes conversacionais (chatbots).

Renascimento da IA – Desde 2010, o poder das máquinas fez com que fosse possível explorar quantidades enormes de dados (big data) com técnicas de aprendizagem profunda, com base no uso de redes neurais formais. Um conjunto de aplicações de sucesso em diversas áreas – incluindo reconhecimento de fala e de imagem, compreensão de língua natural e carros autônomos – está levando a um renascimento da IA.

Simulação de atividade em um microcircuito de neurônios virtuais de um rato (2015), feito pela equipe do “Blue Brain Project” (BBP), parte do “Human Brain Project” europeu (HBP).

Aplicações

Muitas conquistas com o uso de técnicas de IA ultrapassam as capacidades humana. Em 1997, um programa de computador derrotou o campeão mundial de xadrez, e, mais recentemente, em 2016, outros programas de computador venceram os melhores jogadores do mundo de Go (um antigo jogo de tabuleiro chinês) e alguns dos melhores jogadores de pôquer. Os computadores estão provando, ou ajudando a provar, teoremas matemáticos; o conhecimento está sendo construído automaticamente a partir de um volume imenso de dados, em terabytes (1012 bytes), ou mesmo petabytes (1015 bytes), com o uso de técnicas de machine learning.

Como resultado, as máquinas podem identificar um discurso e transcrevê-lo, assim como datilógrafos faziam no passado. Os computadores podem identificar faces ou impressões digitais com precisão entre dezenas de milhões delas, ou podem entender textos escritos em línguas naturais. Com a aplicação das técnicas de machine learning, os carros podem circular sem motorista, máquinas se tornam melhores que dermatologistas no diagnóstico de melanomas ao utilizar imagens de sinais de pele a partir de fotos tiradas com câmeras de telefone celular; robôs estão lutando em guerras no lugar de humanos; e linhas de produção nas fábricas estão se tornando cada vez mais automatizadas.

Os cientistas também estão utilizando estas técnicas para determinar a função de certas macromoléculas biológicas, especialmente proteínas e genomas, a partir das sequências de seus componentes – aminoácidos para proteínas, bases para genomas. De modo mais geral, todas as ciências estão passando por uma enorme ruptura epistemológica com experimentos in silico – nomeados desta maneira por serem realizados por computadores a partir de uma enorme quantidade de dados, que utilizam processadores poderosos cujas centrais são feitas de silicone. Desta maneira, eles se diferem dos experimentos in vivo, feitos em matéria viva, e, acima de tudo, dos experimentos in vitro, feitos em tubos de ensaio de vidro.

Atualmente, as aplicações da IA afetam quase todos os ramos de atividade – particularmente na indústria, em bancos, seguros, setores de saúde e defesa. Muitas tarefas de rotina são agora automatizadas, o que provoca a transformação de diversas transações e, eventualmente, a eliminação de algumas.

Quais são os riscos éticos?

Com a IA, a maioria das dimensões de inteligência – talvez à exceção do humor – está sujeita à análise racional e à reconstrução por meio do uso de computadores. Mais além, as máquinas estão excedendo nossas capacidades cognitivas na maioria das áreas, e gera temores com relação a riscos éticos. Esses riscos recaem em três categorias – a escassez de trabalho, porque este poderá ser feito por máquinas no lugar de humanos; as consequências para a autonomia individual, particularmente em termos de liberdade e segurança; e a dominação da humanidade, que seria substituída por máquinas mais “inteligentes”.

No entanto, se examinarmos a realidade, veremos que o trabalho (feito por humanos) não está desaparecendo, muito pelo contrário, está mudando e demandando novas habilidades. Da mesma forma, a autonomia e a liberdade individuais não são inevitavelmente enfraquecidas pelo desenvolvimento da IA, desde que continuemos vigilantes em face das interferências tecnológicas em nossas vidas privadas.

Finalmente, ao contrário do que algumas pessoas alegam, as máquinas não oferecem nenhuma ameaça existencial para a humanidade. Sua autonomia é puramente tecnológica, e nisso corresponde apenas a cadeias materiais de causalidade que vão da coleta de informação à tomada de decisão. Por outro lado, as máquinas não possuem autonomia moral, porque até elas nos confundem e nos enganam no processo de tomada de decisão, não possuem vontade própria e permanecem subjugadas aos objetivos que damos a elas.

(*) O cientista da computação Jean-Gabriel Ganascia é professor na Universidade Sorbonne, em Paris. Ele também é pesquisador no LIP6, o laboratório de ciência da computação na Sorbonne, membro da European Association for Artificial Intelligence (Associação Europeia de Inteligência Artificial), membro do Institut Universitaire de France e presidente do comitê de ética no Centro Nacional de Pesquisa Científica (CNRS), em Paris. Os interesses de sua atual pesquisa incluem machine learning, fusão de dados simbólicos, ética computacional, ética da informática e humanidades digitais.